Das Datenvolumen wächst in einem noch nie dagewesenen Ausmaß. Ein neues Schlagwort hat damit Einzug in das bereits überfüllte Vokabular der Datenbranche gehalten: das Data Lakehouse.

Wir bei ALTEN haben bereits erfolgreich Datenplattformen mit Data Lakehouses für unsere Kunden eingerichtet und werden dies sicherlich auch in Zukunft tun. Doch was genau hat es damit auf sich?

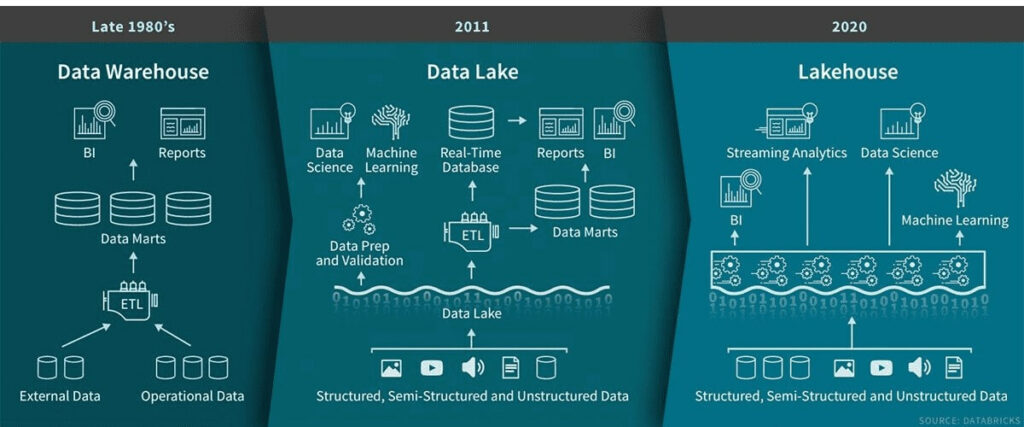

Selbst die weniger datenkundigen Fachleute haben schon von Data Warehouses und Data Lakes gehört, aber jetzt gibt es eine neue Möglichkeit, Daten für Analysezwecke zentral zu speichern: Das Data Lakehouse. Um das Konzept des Data Lakehouse zu verstehen, müssen wir jedoch zunächst einen kurzen Blick auf die Geschichte der analytischen Speicherung werfen.

Die Ursprünge der analytischen Speicherung

Seit dem Beginn der digitalen Revolution in der zweiten Hälfte des 20. Jahrhunderts werden exponentiell wachsende Datenmengen verarbeitet. In den 1960er und 1970er Jahren begann man, Computer für die Abwicklung von Transaktionsaufgaben in Unternehmen einzusetzen, wodurch die bis dahin manuell durchgeführte Aufzeichnung automatisiert wurde.

Mit den Fortschritten bei den Rechen- und Speichertechnologien wuchsen jedoch auch die Datenmengen, was Unternehmen vor ein Problem stellte, als diese versuchten, die gesammelten Daten zu analysieren. Hier kommt das Data Warehouse ins Spiel: eine Datenbank auf Basis einer Single Source of Truth, in der die Daten eines Unternehmens in separaten Datenbanken zentralisiert werden, die für die analytische Nutzung optimiert sind. Diese strukturierte Speicherung von Daten führt jedoch auch zu einer gewissen Unbeweglichkeit. Schemata müssen im Voraus definiert werden und die nachträgliche Implementierung von Änderungen kann mühsam sein, insbesondere bei großen Datenmengen.

Von Datenseen zu Datensümpfen

In den späten 2000er- und frühen 2010er-Jahren überstieg das Volumen der analytischen Daten, die Unternehmen verarbeiten wollten, die Kapazität vieler herkömmlicher, vor Ort installierter Data Warehouses. Das Zeitalter von Big Data war angebrochen. Um diese neuen Herausforderungen zu bewältigen, wurde das Modell der Data Lakes ins Leben gerufen.

Data Lakes können Daten in jedem beliebigen Format speichern und unterstützen auch die Möglichkeit der Datenaufnahme in Echtzeit. Wegen seiner Vorteile entwickelte sich der Data Lake schnell zur ersten Wahl für die Speicherung von analytischen Big Data. Unerfreulicherweise ist die effiziente Implementierung und Verwaltung eines Data Lake jedoch eine Herkulesaufgabe und viele Data Lakes haben sich aufgrund eines mangelnden Managements zu Datensümpfen entwickelt. Diese machen die Datenermittlung fast unmöglich und behindern die erfolgreiche Gewinnung analytischer Erkenntnisse.

Das Beste aus beiden Welten vereinen

In den letzten Jahren wurde daher versucht, das Konzept des Data Warehouse und des Data Lake durch den Einsatz moderner Technologien in Einklang zu bringen. Im Idealfall werden die Effizienz des Data Warehouse und die Flexibilität des Data Lake in einer skalierbaren Lösung kombiniert. Aus diesem Ideal heraus wurde das Konzept des Data Lakehouse entwickelt und dieses wird nun dank der jüngsten technologischen Fortschritte realisiert. Seine Stärke zeigt sich in einer Reihe von Schlüsselmerkmalen, wie die Aufnahme und Analyse von Daten in Echtzeit oder die Kosteneffizienz im Vergleich zu modernen Data Warehouses.

Natürlich bringt jede neue Technologie aber auch ihre Nachteile mit sich. Eines der wichtigsten Argumente, das derzeit gegen Data Lakehouses vorgebracht wird, ist, dass sie noch nicht so ausgereift sind wie ihre Gegenstücke. Nichtsdestotrotz haben inzwischen immer mehr Unternehmen das Lakehouse-Konzept übernommen und festgestellt, dass es bereits so weit ausgereift ist, dass es seine Versprechen in Produktionsszenarien erfüllen kann.

Fazit

Das Data Lakehouse-Konzept ist sehr vielversprechend und stellt in Bezug auf die Architektur von Datenplattformen einen Paradigmenwechsel dar. Die Kombination der hohen Leistung von Data Warehouses mit der Skalierbarkeit und Flexibilität von Data Lakes bietet die Möglichkeit, das Beste aus beiden Welten zu nutzen. Natürlich hatte das Data Lakehouse-Konzept in der Vergangenheit einige Anlaufschwierigkeiten, aber glücklicherweise hat es sich in einem erstaunlichen Tempo weiterentwickelt, das sich in den kommenden Jahren fortsetzen dürfte. Auch wir bei ALTEN sind sicher, dass wir weiterhin solch moderne Datenarchitekturen für unsere Kunden einrichten werden.

Sie benötigen Unterstützung in einem Projekt? Kontaktieren Sie uns!